Tallinna Ülikool

Kvantitatiivne digihumanitaaria

Jaagup Kippar

2019

Sisukord

Arvude kättesaamine kogumist. 8

Filtreerimine, järjestamine 16

Andmetabeli pikk ja lai kuju 35

Üldistamine, proportsioonide test 42

Võrdlus olemasoleva suhtega 47

Vahemike graafiline kuvamine 48

Lugude esimeste sõnade võrdlemine 69

Mitmemõõtmeline skaleerimine (MDS) 120

Tähtede sagedused eesti ja soome keeles 125

Pythoni statistikakäsklused 178

Multidimensionaalne skaleerimine 184

Sissejuhatus

11. klassi koolimatemaatikas tutvutakse põhiliste statistilise andmeanalüüsi mõistete ja arvutuskäikudega ning õpitakse neid kättesaadavate andmete peal kasutama. Sealsed miinimum, maksimum, mediaan ning aritmeetiline keskmine koos standardhälbega on arvutuste aluseks. Nende abiga saab andmetest esialgse ja põhilise ülevaate.

Kooliajast tuttavatele arvutustele lisaks leidub andmete analüüsimiseks ka hulgaliselt muid meetodeid mis - kord üks kord teine - kasulikuks osutuvad. Neid proovides ja kombineerides saab vaadata, et kas andmetest ka midagi sellist välja paistab, mis esimese hooga kohe silma ei jää. Materjali tagumisest poolest leiab mitu meetodit, kus uuritavate tunnuste arvu vähendatakse - nii et algselt mõõdetud mitmest või mitmeteistkümnest jääb vaid mõni alles - ning siis on suhteid ja rühmi juba kergem joonisele kuvada ja sealt seoseid otsida.

Omamoodi harjumist nõuab mõtteviis, kus "jah" või "ei" vastuse asemel öeldakse "95% tõenäosusega võime väita, et" - ja järgneb vastuse eeldatav vahemik. Kui tahetakse väite õiguses kindlam olla, siis tuleb vahemikku laiendada, kui lepitakse sagedasemate valeotsustega, siis saab ka uskuda vastuse suuremasse täpsusesse - paratamatult tuleb ühelt poolt võites mujal järele anda.

Suuremas osas raamatus kasutatakse programmeerimiskeelt nimega R - mis on 2010ndatel taas laialt levima hakanud. Lõpuosas tehakse märgatav osa arvutustest ka Pythoni ja tema lisapakettide abil läbi - nii on pärast meetodite toimimisest aru saamist võimalik valida kahe levinuma andmetöötluskeele seast, kummaga parajasti põhjust lähemalt tegemist teha.

Näited võetakse enamasti keelevaldkonnast - loetakse tekstides sõnu, täishäälkuid ja muid tunnuseid, mis suurelt jaolt lapsepõlvest tuttavad. Eks oma uuringute juures asendab igaüks andmed omale tarvilikega. Arvutab tulemused välja ning siis loodetavasti enne suuremat välja kuulutamist mõtleb enne vähemalt korra, et mida leitud erinevused mingis valdkonnas tähendavad ning kui suure õigsustõenäosuse puhul võib järgmisi järeldusi seni leitutele tuginema panna. Mõndapidi kipub ju ebakindel tunduma, et vastus pole kindel "jah" või "ei". Samas kui arvutuskäik näitab, et vale vastuse tõenäosus on üks miljoni või miljardi kohta, siis see on palju kindlam vastus, kui mõni lihtsalt üle huulte või ekraani tulnud jah-sõna.

Materjalile eelneb digihumanitaaria tehnilisemaid vahendeid üldisemalt tutvustav konspekt "Digihumanitaaria tehnoloogiad" - kui mõni siinne järeldus või arvutus tundub liialt äkiline olema, siis sealt võib leida pikemalt seletavaid ning teisest suunast tulevaid näiteid.

“R on mõnes mõttes kohutav, aga midagi paremat pole ka välja mõeldud” ütles üks meditsiinistatistikaga tegelev tuttav. Siinses materjalis kasutame selle keele abi mitmesuguste teemade seletamisel.

Käivitada on R-i käske alustuseks lihtsam ühekaupa käsurealt. Hiljem saab ka pikemaid programmilõike kokku panna ning neid eraldi tööle lükata.

Kui Linuxi alla R installitud, siis piisab käivitamiseks üldiselt üherealisest käsust

R

Mujal tuleb paigaldada eraldi R keskkond soovi korral koos värvilisema R-studioga. Sõltumata ettevalmistuskohast, on lõpuks ikkagi silme ees käsuviip

>

Anname käske ette, tema annab vastused vastu. Kirjutame 3+2, saame vastuseks 5. Kantsulgudes üks vastuse ees näitab, et tegemist on esimese vastusega. Kuna andmeanalüüsi juures võib andmeid ja vastuseid palju olla, siis tuleb nummerdamine kasuks.

> 3+2

[1] 5

Muud tavalised tehtemärgid -, * ja / on lahutamise, korrutamise ja jagamise kohta. Astendamiseks sobib kaks järjestikust korrutusmärki

> 2**5

[1] 32

ruutjuure võtmiseks käsklus sqrt.

> sqrt(25)

[1] 5

Andmete meelde jätmiseks muutujad.

Soovituslikuks omistuskäsuks R-keeles on noole ehk siis “väiksem kui” ja miinusmärgi kombinatsiooni abil omistamine. Muutuja väärtust saab näha lihtsalt selle nime trükkides

> pikkus <- 168

> pikkus

[1] 168

Nool võib olla ka teises suunas

> 169 -> pikkus

> pikkus

[1] 169

Töötab ka mitmest muust keelest tuttav võrdusmärgiga omistamine

> pikkus=165

> pikkus/100

[1] 1.65

> 3*5

[1] 15

> 26000/1320000

[1] 0.01969697

> (26000/1320000)*100

[1] 1.969697

> round((26000/1320000)*100, 2)

[1] 1.97

> paste(round((26000/1320000)*100, 2), '%')

[1] "1.97 %"

> 296/26000

[1] 0.01138462

> 296/26000*1320000

[1] 15027.69

Lihtsamaks neist vektor ehk kollektsioon, kus sama tüüpi väärtused reas on. R-i kasulik eripära, et kogumiga võib tehteid teha peaaegu sama vabalt kui üksikute väärtustega. Lihtsamaks üksikute väärtuste ritta kokku kogumise käsuks on c - nagu collection

> pikkused <- c(165, 172, 180)

Liidan väärtustele ühe ja näengi tulemust

> pikkused+1

[1] 166 173 181

Sama sentimeetriteks arvutamise juures

> pikkused/100

[1] 1.65 1.72 1.80

Lubatakse liita ka terve sama pikk andmevektor korraga

> pikkused <- c(165, 172, 180)

> kontsad <- c(1, 5, 2)

> pikkused + kontsad

[1] 166 177 182

Suurem kogus andmeid on mugav sisse lugeda failist - näiteks veebis asuvast failist.

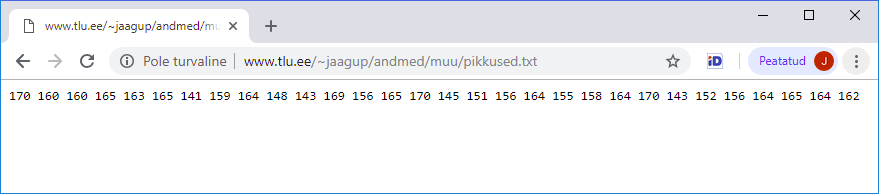

Aadressilt

http://www.tlu.ee/~jaagup/andmed/muu/pikkused.txt

leiab arvud

170 160 160 165 163 165 141 159 164 148 143 169 156 165 170 145 151 156 164 155 158 164 170 143 152 156 164 165 164 162

Arvurea sisse lugemiseks sobib käsklus scan

> pikkused <- scan("http://www.tlu.ee/~jaagup/andmed/muu/pikkused.txt")

Read 30 items

Edasi tavalised arvujada arvutused.

Vähim:

> min(pikkused)

[1] 141

Suurim:

> max(pikkused)

[1] 170

Aritmeetiline keskmine

> mean(pikkused)

[1] 158.9

Mediaan:

> median(pikkused)

[1] 161

Vahemik vähimast suurimani:

> range(pikkused)

[1] 141 170

Kokkuvõte andmetest: vähim, esimene veerand (millest 25% arvudest väiksemad), mediaan, aritmeetiline keskmine, kolmas veerand, maksimum.

> summary(pikkused)

Min. 1st Qu. Median Mean 3rd Qu. Max.

141.0 155.2 161.0 158.9 164.8 170.0

Kõigepealt arvude kogus

> length(pikkused)

[1] 30

ja arvud ise

> pikkused

[1] 170 160 160 165 163 165 141 159 164 148 143 169 156

[14] 165 170 145 151 156 164 155 158 164 170 143 152 156

[27] 164 165 164 162

Andmete algusots - ülevaade suuremast kogumist

> head(pikkused)

[1] 170 160 160 165 163 165

Esimene element. Tähelepanuks, et erinevalt näiteks Pythonist hakkab siin lugemine ühest

> pikkused[1]

[1] 170

Teine element

> pikkused[2]

[1] 160

Loetelus viimased

> tail(pikkused)

[1] 152 156 164 165 164 162

Viimane element ehk element, mille järjekorranumbriks on elementide koguarv

> pikkused[length(pikkused)]

[1] 162

Tundmatu arvukogumi uurimiseks soovitatakse teha kõigepealt ülevaateks histogramm.

> hist(pikkused)

Tegemist kõrvuti tulpadega oleva diagrammiga, kus iga vahemiku puhul näha, et mitu arvu sellesse satub. Nii tekib silme ette ülevaade arvude jaotusest. Joonise koostamisele saab aga ka vihjeid anda, kui soovida midagi rõhutada, pehmendada või lihtsalt mugavamalt vaadatavaks teha. Saab anda soovitusliku katkestuskohtade arvu

> hist(pikkused, breaks=3)

R aga katsub leida tasakaalu soovitu ning mõistliku vahel ning kümne küsitud koha asemel tuleb praeguse arvukoguse juures vaid kuus tulpa.

> hist(pikkused, breaks=10)

Võib ka määrata sentimeetrid, kus tulbad osadeks jaotatakse. Eripikkuste vahemike puhul näidatakse aga mitte üldarvu, vaid suhtelist tihedust, nii et pindala järgi paistab, kui ühtlaselt on tulemused vahemikku “laiali määritud”

> hist(pikkused, breaks=c(130, 145, 165, 190))

Nihutades viimast vahet veidi edasi, muutub aga praeguse väikese arvukoguse juures pilt märgatavalt

> hist(pikkused, breaks=c(130, 145, 175, 190))

Joonistele on viisakas lisada pealkiri ning telgede kirjeldused

> hist(pikkused, main = "Pikkuste jaotus", xlab="cm", ylab="kogus")

Värvimisnäide

> hist(pikkused, col="red")

Kui jooniseid koostada Linuxi käsureal näiteks putty terminaliaknas, siis tuleb joonise nägemiseks pärast selle koostamist kirjutada käsklus dev.off()

Tulemusena salvestatakse joonis aktiivses kataloogis olevasse faili nimege Rplots.pdf

Faili saab avada kas koha peal või siis kopeerides kohalikku masinasse ja seal uurides.

> pikkused<-scan("http://www.tlu.ee/~jaagup/andmed/muu/pikkused.txt")

Read 30 items

> hist(pikkused, col="red")

> dev.off()

null device

1

> min(sonapikkused)

[1] 2

> summary(sonapikkused)

Min. 1st Qu. Median Mean 3rd Qu.

2.000 2.000 3.000 3.444 4.000

Max.

6.000

>

> hist(sonapikkused, main="Sõnade pikkuste jaotus",

xlab="pikkus", ylab="kogus")

Kogumist saab andmed küsida välja vastavalt tingimusele. Näiteks 160 sentimeetrist lühemad pikkused

> pikkused[pikkused<160]

[1] 141 159 148 143 156 145 151 156 155 158 143 152 156

Madalama piiri puhul tuleb ka pikkusi vähem

> pikkused[pikkused<155]

[1] 141 148 143 145 151 143 152

Järjestamiseks sobib käsklus sort

> sort(pikkused[pikkused<155])

[1] 141 143 143 145 148 151 152

Järjestatud pikkused täppidena joonisele. Joonise x-teljeks võetakse järjekorranumber ehk indeks ning y-teljeks väärtus

> plot(sort(pikkused[pikkused<155]))

Nagu histogrammi, nii ka karpdiagrammi peetakse heaks mooduseks arvukogumist ülevaate andmisel. Keskmine rasvane joon on mediaan. Keskel oleva karbi alumine külg alumine kvartiil - millest on väiksemaid väärtusi veerand - ning ülemine külg ülemine kvartiil. Karbi küljes olevad vurrud näitavad maad vähima ja suurima väärtuseni.

> boxplot(pikkused)

Kogumisse väärtuse lisamiseks tehakse uus nõnda, et sinna jäetakse vana sisu + juurde veel vajalik element.

> pikkused<-c(pikkused, 52)

> pikkused

[1] 170 160 160 165 163 165 141 159 164 148 143 169 156 165 170

[16] 145 151 156 164 155 158 164 170 143 152 156 164 165 164 162

[31] 52

Nii paistab, et see vastsündinud lapse pikkus ka loetelus juures.

Kui mõni väärtus on teistest väga erinev, siis boxplot ei paiguta seda üldise karpdiagrammi hulka, vaid näitab punktina eraldi.

> boxplot(pikkused)

Eelnevas näites muutsime pikkuste kogumit. Siin kuvamise juures lisame joonisele juurde küll ühe 202-sentimeetri pikkuse korvpalluri, aga ei paiguta teda pikkuste kogumisse.

> boxplot(c(pikkused, 202))

sonad=c("mu", "isamaa", "on", "minu", "arm", "kel", "südant", "andnud", "ma")

sonapikkused=c(2, 7, 2, 4, 3, 3, 6, 6, 2)

plot(sonapikkused)

plot(sonapikkused, type="n")

text(1:length(sonapikkused), sonapikkused, sonad)

R-i “kohutavat” süsteemitust on püütud parandada mitmete lisateekidega. Neist populaarsemaks osutunud ning omavahel enamvähem ühilduvad on kogutud teeki nimega tidyverse.

Teegid ehk lisapaketid on üldsegi programmeerimiskeelte juures päris tähtsad. Uue teema alustamisel ja keele/vahendite valikul võib keele mugavusest või tuntusest määravamaks osutuda vajalike pakettide olemasolu. Näiteks geneetikas on R valitseval kohal justnimelt valdkonnas arendatud paljude tarvilike teekide tõttu.

Esimesel korral kasutamiseks tuleb teek installida (kui seda automaatselt juba sees ei ole). Käskluseks siinsel juhul

> install.packages("tidyverse")

Tulemusena ragistab masin mõne kuni mõnikümmend minutit ning õiguste ja kettamahu sobivuse korral sikutab paketi kohale. Edasi see on juba olemas ning järgmistel kordadel piisab kasutamiseks vaid teegi sisse lugemisest.

> library(tidyverse)

Loading tidyverse: ggplot2

Loading tidyverse: tibble

Loading tidyverse: tidyr

Loading tidyverse: readr

Loading tidyverse: purrr

Loading tidyverse: dplyr

Conflicts with tidy packages ------------------------------

filter(): dplyr, stats

lag(): dplyr, stats

Andmeid on mugav sisse lugeda csv-failist

Selleks tidyverse puhul sobib käsklus read_csv

>sonad=read_csv("http://www.tlu.ee/~jaagup/andmed/keel/kunglarahvas_lambipirn_pikkused_haalikud.txt")

Parsed with column specification:

cols(

lugu = col_character(),

sona = col_character(),

sonapikkus = col_integer(),

taishaalikuid = col_integer(),

sulghaalikuid = col_integer()

)

Andmete algusotsast annab ülevaate head

> head(sonad)

# A tibble: 6 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla kui 3 2 1

2 kungla kungla 6 2 2

3 kungla rahvas 6 2 0

4 kungla kuldsel 7 2 2

5 kungla aal 3 2 0

6 kungla kord 4 1 2

lõpuotsast tail

> tail(sonad)

# A tibble: 6 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 lambipirn pea 3 2 1

2 lambipirn kuklas 6 2 2

3 lambipirn ja 2 1 0

4 lambipirn suu 3 2 0

5 lambipirn pärani 6 3 1

6 lambipirn lahti 5 2 1

juhuslikest kohtadest ülevaade käsuga sample_n, praegusel juhul kokku kümme rida

> sample_n(sonad, 10)

# A tibble: 10 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 lambipirn siin 4 2 0

2 lambipirn millesti 8 3 1

3 lambipirn enne 4 2 0

4 kungla hääl 4 2 0

5 lambipirn istuvad 7 3 2

6 lambipirn jne 3 1 0

7 kungla laulis 6 3 0

8 lambipirn jne 3 1 0

9 lambipirn matemaatik 10 5 3

10 kungla vanemuine 9 5 0

Dollarimärgi abil saab tabeli tulba sõnad kätte eelnevalt tuttava vektorina

> sonad$sona

[1] "kui" "kungla"

[3] "rahvas" "kuldsel"

[5] "aal" "kord"

[7] "istus" "maha"

[9] "sööma" "siis"

[11] "vanemuine" "murumaal"

Sealt võimalik järjekorranumbri järgi vastus küsida. Sõna "kungla" on laulus teisel kohal. Kantsulgudes üks näitab, et tegemist on esimese (ja praegusel juhul ainukese) vastusega.

> sonad$sona[2]

[1] "kungla"

Laulu alguse sõnade kätte saamiseks samuti käsklus head

> head(sonad$sona, 10)

[1] "kui" "kungla" "rahvas" "kuldsel" "aal" "kord"

[7] "istus" "maha" "sööma" "siis"

Tulpadeks olevatele andmevektoritele saab rahus rakendada eelnevalt tuttavaid funktsioone. Siin näiteks leitakse suurim sõnapikkus.

> max(sonad$sonapikkus)

[1] 19

Erinevad väärtused toob välja käsk unique

> unique(sonad$lugu)

[1] "kungla" "lambipirn"

Andmetega mängimine ehk data wrangling on R-i üks tähtis osa. Järjestamiseks käsklus arrange

> arrange(sonad, sonapikkus)

# A tibble: 672 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla ja 2 1 0

2 kungla ja 2 1 0

3 kungla ja 2 1 0

Kahanevasse järjekorda panekuks saab järjestada negatiivse sõnapikkuse järgi

> arrange(sonad, -sonapikkus)

# A tibble: 672 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 lambipirn politseijaoskonnale 19 9 3

2 lambipirn intelligentselt 15 5 4

3 lambipirn funktsioneeriva 15 7 2

4 lambipirn märkimisväärset 15 6 2

5 lambipirn valgusallikata 14 6 3

tekstiliste andmete puhul tuleb aga abiliseks desc

> arrange(sonad, desc(sona))

# A tibble: 672 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 lambipirn üllatuslikult 13 5 3

2 lambipirn üles 4 2 0

3 lambipirn üldjoontes 10 4 2

4 lambipirn üks 3 1 1

Filtreerimiseks ehk sobivate alles jätmiseks käsklus filter

> filter(sonad, lugu=="kungla")

# A tibble: 75 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla kui 3 2 1

2 kungla kungla 6 2 2

3 kungla rahvas 6 2 0

4 kungla kuldsel 7 2 2

5 kungla aal 3 2 0

Käske võib sobivalt üksteise sisse paigutada. Kõigepealt jäetakse alles Kungla rahva sõnad ning siis järjestatakse kahanevalt sõnapikkuse järgi

> arrange(filter(sonad, lugu=="kungla"), desc(sonapikkus))

# A tibble: 75 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla vanemuine 9 5 0

2 kungla laululugu 9 5 1

3 kungla lauluviis 9 5 0

4 kungla vanemuise 9 5 0

5 kungla murumaal 8 4 0

6 kungla murueide 8 5 1

7 kungla kuldsel 7 2 2

8 kungla mängima 7 3 1

Pikemate päringute puhul saab aga üksteise sees olevaid sulge nõndamoodi palju ning paremaks peetakse süntaksikuju, kus andmed igast käsust järgmisesse %>% operaatori abil edasi suunatakse

> sonad %>% filter(lugu=="kungla")

# A tibble: 75 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla kui 3 2 1

2 kungla kungla 6 2 2

3 kungla rahvas 6 2 0

4 kungla kuldsel 7 2 2

5 kungla aal 3 2 0

Sealt vajaduse korral omakorda edasi, nii et pikemates päringutes võib sarnaseid suunamisi üle kümne olla

> sonad %>% filter(lugu=="kungla") %>% arrange(desc(sonapikkus))

# A tibble: 75 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla vanemuine 9 5 0

2 kungla laululugu 9 5 1

3 kungla lauluviis 9 5 0

4 kungla vanemuise 9 5 0

5 kungla murumaal 8 4 0

6 kungla murueide 8 5 1

7 kungla kuldsel 7 2 2

8 kungla mängima 7 3 1

Nii saab käsku vajadusel ka mitmele reale jagada, suunamisoperaator aga peab jääma rea lõppu.

sonad %>%

filter(lugu=="kungla") %>%

arrange(desc(sonapikkus))

Käsureaaknas näidatakse senikaua rea algul plussmärke, kui arvatakse, et käsklus läheb veel edasi

> sonad %>%

+ filter(lugu=="kungla") %>%

+ arrange(desc(sonapikkus))

# A tibble: 75 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla vanemuine 9 5 0

2 kungla laululugu 9 5 1

3 kungla lauluviis 9 5 0

4 kungla vanemuise 9 5 0

5 kungla murumaal 8 4 0

6 kungla murueide 8 5 1

7 kungla kuldsel 7 2 2

8 kungla mängima 7 3 1

Suuremas päringus on nõnda võimalik soovi korral etappe kommenteerimise abil ka ajutiselt eraldada - praegu järjestatakse kõikide tabelis olevate laulude sõnad

sonad %>%

#filter(lugu=="kungla") %>%

arrange(desc(sonapikkus))

> sonad %>%

+ #filter(lugu=="kungla") %>%

+ arrange(desc(sonapikkus))

# A tibble: 672 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 lambipirn politseijaoskonnale 19 9 3

2 lambipirn intelligentselt 15 5 4

3 lambipirn funktsioneeriva 15 7 2

4 lambipirn märkimisväärset 15 6 2

5 lambipirn valgusallikata 14 6 3

6 lambipirn topsivendadelt 14 5 5

7 lambipirn naerukrampides 14 6 3

8 lambipirn reflektoorsete 14 6 3

9 lambipirn kodumaalastel 13 6 3

10 lambipirn elektrituruga 13 6 4

# ... with 662 more rows

Tabelis lihtsaimaks kokkuvõtete arvutamiseks sobib käsklus summarise. Parameetrina tuleb ette lugeda, mida arvutada soovitakse ning kuidas uued tulbad nimetatakse

> sonad %>% summarise(sonadearv=n(), aritmkeskmine=mean(sonapikkus), mediaan=median(sonapikkus))

# A tibble: 1 x 3

sonadearv aritmkeskmine mediaan

<int> <dbl> <dbl>

1 672 5.76 5

Soovides tulemusi rühmitada ühe tunnuse erinevate väärtuste - näiteks laulunime kaupa, siis tuleb vahele paigutada group_by

sonad %>% group_by(lugu) %>%

summarise(sonadearv=n(), aritmkeskmine=mean(sonapikkus), mediaan=median(sonapikkus))

# A tibble: 2 x 4

lugu sonadearv aritmkeskmine mediaan

<chr> <int> <dbl> <int>

1 kungla 75 4.76 4

2 lambipirn 597 5.89 5

Nii näeb ridade kaupa tulemusi kummagi laulu kohta eraldi. Tegemist levinud võimalusega, kus saab vabalt valida, millise tunnuse järgi andmestikku rühmadeks jaotada ning milliseid käsklusi nendele andmetele rakendada.

Lahendusi

Täishäälikute andmed laulude kaupa

sonad %>% group_by(lugu) %>%

summarise(taish_keskm=mean(taishaalikuid), taish_mediaan=median(taishaalikuid))

# A tibble: 2 x 3

lugu taish_keskm taish_mediaan

<chr> <dbl> <int>

1 kungla 2.27 2

2 lambipirn 2.67 2

Sulghäälikute arv täishäälikute arvu kaupa

sonad %>% group_by(taishaalikuid) %>%

summarise(min_sulg=min(sulghaalikuid), max_sulg=max(sulghaalikuid))

# A tibble: 9 x 3

taishaalikuid min_sulg max_sulg

<int> <dbl> <dbl>

1 0 0 0

2 1 0 2

3 2 0 3

4 3 0 4

5 4 0 5

6 5 0 5

7 6 1 4

8 7 2 2

9 9 3 3

Kungla rahva laulus täishäälikute arvud sulghäälikute arvu kaupa

sonad %>% filter(lugu=="kungla") %>% group_by(sulghaalikuid) %>%

summarise(taish_keskm=mean(taishaalikuid), taish_mediaan=median(taishaalikuid))

# A tibble: 4 x 3

sulghaalikuid taish_keskm taish_mediaan

<int> <dbl> <dbl>

1 0 2.19 2

2 1 2.45 2

3 2 1.88 2

4 3 2.5 2.5

Kõikidest arvulistest tulpadest ühe käsu abil võetud keskmine

sonad %>% group_by(lugu) %>% summarise_if(is.numeric, mean)

# A tibble: 2 x 4

lugu sonapikkus taishaalikuid sulghaalikuid

<chr> <dbl> <dbl> <dbl>

1 kungla 4.76 2.27 0.68

2 lambipirn 5.89 2.67 1.32

Aritmeetiline keskmine ja mediaan kõikidest arvulistest tulpadest

> sonad %>% group_by(lugu) %>% summarise_if(is.numeric, c(aritmkesk=mean, mediaan=median))

# A tibble: 2 x 7

lugu sonapikkus_arit~ taishaalikuid_a~ sulghaalikuid_a~ sonapikkus_medi~ taishaalikuid_m~

<chr> <dbl> <dbl> <dbl> <int> <int>

1 kung~ 4.76 2.27 0.68 4 2

2 lamb~ 5.89 2.67 1.32 5 2

# ... with 1 more variable: sulghaalikuid_mediaan <int>

Kuna tulpade nimed läksid pikaks ja tulemus ei mahtunud ekraanile, siis tekstiaknas näidati seda lühemalt. Graafilise lahenduse puhul võimalik vaadata sama tulemust mugavamalt View-käsu abil

> View(sonad %>% group_by(lugu) %>% summarise_if(is.numeric, c(aritmkesk=mean, mediaan=median)))

Üheks mooduseks tulbad paremini silmade ette meelitada on nad ümber nimetada. Siis tuleb alt välja, et sp_a on sõnapikkuse aritmeetiline keskmine ning th_med on täishäälikute arvu mediaan

sonad %>% rename(sp=sonapikkus, th=taishaalikuid, sh=sulghaalikuid) %>%

summarise_if(is.numeric, c(a=mean, med=median))

# A tibble: 1 x 6

sp_a th_a sh_a sp_med th_med sh_med

<dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

1 5.76 2.62 1.25 5 2 1

Kui sama tulemust tahta kummagi teksti kohta eraldi, siis tuleb andmestik kõigepealt loo järgi grupeerida

sonad %>%

group_by(lugu) %>%

rename(sp=sonapikkus, th=taishaalikuid, sh=sulghaalikuid) %>%

summarise_if(is.numeric, c(a=mean, med=median))

# A tibble: 2 x 7

lugu sp_a th_a sh_a sp_med th_med sh_med

<chr> <dbl> <dbl> <dbl> <int> <int> <int>

1 kungla 4.76 2.27 0.68 4 2 1

2 lambipirn 5.89 2.67 1.32 5 2 1

Loo nimi jääb rühma eristavaks tunnuseks. Kui select-käsuga eemaldan sõnade tulba, siis kõik arvutamisel alles jäävad tulbad ongi juba arvulised ning kasutada võin summarise_if-i asemel käsku summarise_all

sonad %>% select(-sona) %>% group_by(lugu) %>% summarise_all(mean)

# A tibble: 2 x 4

lugu sonapikkus taishaalikuid sulghaalikuid

<chr> <dbl> <dbl> <dbl>

1 kungla 4.76 2.27 0.68

2 lambipirn 5.89 2.67 1.32

Kui ei rühmita ja jätab alles kõik arvulised tulbad, siis saab sama käsklust ka neile mugavasti rakendada

sonad %>% select(-c(lugu, sona)) %>% summarise_all(mean)

# A tibble: 1 x 3

sonapikkus taishaalikuid sulghaalikuid

<dbl> <dbl> <dbl>

1 5.76 2.62 1.25

Sama tulemus ka juhul, kui välja küsida arvulised tulbad ning siis neile funktsioon rakendada

> sonad %>% select_if(is.numeric) %>% summarise_all(mean)

# A tibble: 1 x 3

sonapikkus taishaalikuid sulghaalikuid

<dbl> <dbl> <dbl>

1 5.76 2.62 1.25

Võib ka mitu arvutust korraga ette anda

> sonad %>% select_if(is.numeric) %>% summarise_all(c(a=mean, med=median))

# A tibble: 1 x 6

sonapikkus_a taishaalikuid_a sulghaalikuid_a sonapikkus_med taishaalikuid_med sulghaalikuid_med

<dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

1 5.76 2.62 1.25 5 2 1

Kõigepealt näide tekstist lõigu välja võtmiseks. Käsklus str_sub eraldab lõigu soovitud kohtade vahel, praegu "tere" juures esimesest teise täheni.

> str_sub("tere", 1, 2)

[1] "te"

Funktsiooni saab kõigi tulpade ümbernimetamiseks rakendada käsu rename_all abil. Punkt täistab parasjagu aktiivset tulbanime. Sellest jäetakse alles vaid kaks esimest tähte ning ongi nimetused lühemad: lu=lugu, so on nii sõna kui sõnapikkus.

> sonad %>% rename_all(funs(str_sub(., 1, 2)))

# A tibble: 672 x 5

lu so so ta su

<chr> <chr> <int> <int> <int>

1 kungla kui 3 2 1

2 kungla kungla 6 2 2

Et aga is.numeric-funktsiooni abil vaid arvulised tulbad alles jäävad, siis saab tehte ikka arusaadavalt ette võtta

sonad %>%

select_if(is.numeric) %>%

rename_all(funs(str_sub(., 1, 2))) %>%

summarise_all(c(a=mean, med=median))

# A tibble: 1 x 6

so_a ta_a su_a so_med ta_med su_med

<dbl> <dbl> <dbl> <dbl> <dbl> <dbl>

1 5.76 2.62 1.25 5 2 1

Märgatavalt erinevaid algandmeid saab võrrelda, kui võrrelda suhteid väärtuste vahel.

Alustuseks juurde tulp muudest kaashäälikutest, mis pole sulghäälikud

> sonad %>% mutate(muud_kaash=sonapikkus-taishaalikuid-sulghaalikuid)

# A tibble: 672 x 6

lugu sona sonapikkus taishaalikuid sulghaalikuid muud_kaash

<chr> <chr> <int> <int> <int> <int>

1 kungla kui 3 2 1 0

2 kungla kungla 6 2 2 2

3 kungla rahvas 6 2 0 4

Sõnapikkuste keskmise arvutus

> mean(sonad$sonapikkus)

[1] 5.763393

Nüüd saab juba sõnapikkust võrrelda tabeli keskmise sõnapikkusega. Paistab, et kolmetäheline "kui" on veidi üle poole keskmise pikkuse ning kuuetäheline "kui" veidi üle sõnade keskmise pikkuse

> sonad %>% mutate(suhtelinesonapikkus=sonapikkus/mean(sonapikkus))

# A tibble: 672 x 6

lugu sona sonapikkus taishaalikuid sulghaalikuid suhtelinesonapikkus

<chr> <chr> <int> <int> <int> <dbl>

1 kungla kui 3 2 1 0.521

2 kungla kungla 6 2 2 1.04

3 kungla rahvas 6 2 0 1.04

4 kungla kuldsel 7 2 2 1.21

5 kungla aal 3 2 0 0.521

Lugude kaupa võrreldes paistab, et Kungla rahva kõik sõnad on keskmiselt veidi rohkem kui ühe tähe võrra lühemad

> sonad %>% group_by(lugu) %>% summarise(keskminepikkus=mean(sonapikkus))

# A tibble: 2 x 2

lugu keskminepikkus

<chr> <dbl>

1 kungla 4.76

2 lambipirn 5.89

Nii põhjust arvutada sõnade suhteline pikkus võrrelduna vastava teksti sõnade keskmise pikkusega

> sonad %>% group_by(lugu) %>% mutate(suhtelinekeskminepikkus=sonapikkus/mean(sonapikkus))

# A tibble: 672 x 6

# Groups: lugu [2]

lugu sona sonapikkus taishaalikuid sulghaalikuid suhtelinekeskminepikkus

<chr> <chr> <int> <int> <int> <dbl>

1 kungla kui 3 2 1 0.630

2 kungla kungla 6 2 2 1.26

3 kungla rahvas 6 2 0 1.26

4 kungla kuldsel 7 2 2 1.47

5 kungla aal 3 2 0 0.630

Väljundit vaadates paistab, et andmed on jäänud grupeerituks lugude kaupa. Et see võib hilisemate arvutuste juures üllatusi põhjustada, siis lisatakse järgmisele käsule ungroup ja jäetakse ühtlasi alles vaid edaspidi vajalikud tulbad. Tähelepanu juhtimiseks, et summarise arvutab tulemus rühmade kaupa, nii et iga rühma (näiteks teksti) kohta jääb üks rida. Käsk mutate aga jätab kõik read alles ning lihtsalt arvutuse sees saab rühma pealt kokku arvutatud tulemusi kasutada.

sonad %>% group_by(lugu) %>%

mutate(suhtelinekeskminepikkus=sonapikkus/mean(sonapikkus),

keskminepikkus=mean(sonapikkus)) %>%

ungroup() %>%

select(lugu, sona, sonapikkus, keskminepikkus, suhtelinekeskminepikkus)

# A tibble: 672 x 5

lugu sona sonapikkus keskminepikkus suhtelinekeskminepikkus

<chr> <chr> <int> <dbl> <dbl>

1 kungla kui 3 4.76 0.630

2 kungla kungla 6 4.76 1.26

3 kungla rahvas 6 4.76 1.26

4 kungla kuldsel 7 4.76 1.47

5 kungla aal 3 4.76 0.630

Andmete illustreerimiseks väike karpdiagramm: x-teljel loo nimi ning y-teljel sõnapikkuste jaotus selles loos.

ggplot(sonad, aes(lugu, sonapikkus)) + geom_boxplot()

Lahendusi

Suurim sõnapikkus tekstis

> sonad %>% group_by(lugu) %>% summarise(suurimpikkus=max(sonapikkus))

# A tibble: 2 x 2

lugu suurimpikkus

<chr> <dbl>

1 kungla 9

2 lambipirn 19

Iga sõna pikkuse suhe teksti pikimasse sõnasse

sonad %>% group_by(lugu) %>%

mutate(suhemaxpikkus=sonapikkus/max(sonapikkus)) %>%

ungroup() %>%

select(lugu, sona, sonapikkus, suhemaxpikkus)

# A tibble: 672 x 4

lugu sona sonapikkus suhemaxpikkus

<chr> <chr> <int> <dbl>

1 kungla kui 3 0.333

2 kungla kungla 6 0.667

3 kungla rahvas 6 0.667

4 kungla kuldsel 7 0.778

5 kungla aal 3 0.333

Sama omistatuna eraldi muutujasse

sonadsuhemax <-

sonad %>% group_by(lugu) %>%

mutate(suhemaxpikkus=sonapikkus/max(sonapikkus)) %>%

ungroup() %>%

select(lugu, sona, sonapikkus, suhemaxpikkus)

Vastuse lõpuosa teise teksti väärtuste nägemiseks

sonadsuhemax %>% tail()

# A tibble: 6 x 4

lugu sona sonapikkus suhemaxpikkus

<chr> <chr> <int> <dbl>

1 lambipirn pea 3 0.158

2 lambipirn kuklas 6 0.316

3 lambipirn ja 2 0.105

4 lambipirn suu 3 0.158

5 lambipirn pärani 6 0.316

6 lambipirn lahti 5 0.263

Kungla rahvast sõnad, mille pikkus on vähem kui pool vastava teksti pikima sõna pikkusest

> sonadsuhemax %>% filter(lugu=="kungla" & suhemaxpikkus<0.5)

# A tibble: 38 x 4

lugu sona sonapikkus suhemaxpikkus

<chr> <chr> <int> <dbl>

1 kungla kui 3 0.333

2 kungla aal 3 0.333

3 kungla kord 4 0.444

4 kungla maha 4 0.444

Vastavate "lühemate" sõnade arv tekstis

> sonadsuhemax %>% filter(lugu=="kungla" & suhemaxpikkus<0.5) %>% nrow()

[1] 38

Sõnade üldarv tekstis

> sonadsuhemax %>% filter(lugu=="kungla") %>% nrow()

[1] 75

Kuni poole pikkusega sõnade arvu suhe vastava teksti sõnade üldarvu

> 38/75

[1] 0.5066667

Sama teise teksti puhul

> sonadsuhemax %>% filter(lugu=="lambipirn" & suhemaxpikkus<0.5) %>% nrow()

[1] 528

> sonadsuhemax %>% filter(lugu=="lambipirn") %>% nrow()

[1] 597

> 528/597

[1] 0.8844221

Arvutus mõlema tekstiga korraga. Leiame kõigepealt tulba näitamaks, kas vastava sõna pikkus on vähem kui pool selle teksti suurimast sõnapikkusest

> sonadsuhemax %>% mutate(lyhem=suhemaxpikkus<0.5)

# A tibble: 672 x 5

lugu sona sonapikkus suhemaxpikkus lyhem

<chr> <chr> <int> <dbl> <lgl>

1 kungla kui 3 0.333 TRUE

2 kungla kungla 6 0.667 FALSE

3 kungla rahvas 6 0.667 FALSE

4 kungla kuldsel 7 0.778 FALSE

5 kungla aal 3 0.333 TRUE

Andmed grupeerituna loo ning jah/ei väärtuse kaupa ja tulemused kokku loetud

> sonadsuhemax %>% mutate(lyhem=suhemaxpikkus<0.5) %>%

+ group_by(lugu, lyhem) %>% summarise(kogus=n())

# A tibble: 4 x 3

# Groups: lugu [?]

lugu lyhem kogus

<chr> <lgl> <int>

1 kungla FALSE 37

2 kungla TRUE 38

3 lambipirn FALSE 69

4 lambipirn TRUE 528

Lambipirni loo puhul paistab välja, et enamik sõnu (528) on lühemad kui pool suurimast sõnapikkusest - põhjuseks mõned hästi pikad sõnad tekstis, mis maksimumi üles viivad.

Eelmine arvutus veidi lühemalt - loetakse kokku sõnade arv, mille pikkus ületab poole suurimast sõnapikkusest tekstis

> sonadsuhemax %>% group_by(lugu) %>% summarise(lyhem=length(sona[suhemaxpikkus<0.5]))

# A tibble: 2 x 2

lugu lyhem

<chr> <int>

1 kungla 38

2 lambipirn 528

Või veel lühemalt: liidetakse kokku jah-vastused tingimusele

> sonadsuhemax %>% group_by(lugu) %>% summarise(lyhem=sum(suhemaxpikkus<0.5))

# A tibble: 2 x 2

lugu lyhem

<chr> <int>

1 kungla 38

2 lambipirn 528

Juurde ka lühemate sõnade suhtarv kogu teksti sõnade arvu suhtes

> sonadsuhemax %>% group_by(lugu) %>%

summarise(lyhem=sum(suhemaxpikkus<0.5), kokku=n(), suhe=lyhem/kokku)

# A tibble: 2 x 4

lugu lyhem kokku suhe

<chr> <int> <int> <dbl>

1 kungla 38 75 0.507

2 lambipirn 528 597 0.884

Samu andmeid saab hoida ja kuvada mitmel moel, valik tehakse sageli kasutusotstarbe järgi. Alljärgnev näide kahe siianigi võrreldud teksti andmete vahel. Laia kuju on ehk silmaga kergem haarata - näeb, väärtusi ridu ja veerge pidi kõrvuti. Pika kuju eeliseks jälle mugavam võimalus programmiga andmete poole pöörduda ka juhul, kui tunnuseid peaks hiljem juurde tulema. Tabeli tulpasid ikka kolm tükki - lugu, tunnus ja väärtus - vajalikke ridu saab lihtsalt loo või tunnuse järgi välja filtreerida.

Pikk: lugu tunnus vaartus <chr> <chr> <dbl> 1 kungla sonapikkus 4.76 2 lambipirn sonapikkus 5.89 3 kungla taishaalikuid 2.27 4 lambipirn taishaalikuid 2.67 5 kungla sulghaalikuid 0.68 6 lambipirn sulghaalikuid 1.32 | Lai: lugu sonapikkus taishaalikuid sulghaalikuid <chr> <dbl> <dbl> <dbl> 1 kungla 4.76 2.27 0.68 2 lambipirn 5.89 2.67 1.32 |

Juurde ka käsud algsest sõnade tabelist sinnani jõudmiseks

> library(tidyverse)

> sonad=read_csv("http://www.tlu.ee/~jaagup/andmed/keel/kunglarahvas_lambipirn_pikkused_haalikud.txt")

> head(sonad)

# A tibble: 6 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla kui 3 2 1

2 kungla kungla 6 2 2

3 kungla rahvas 6 2 0

4 kungla kuldsel 7 2 2

5 kungla aal 3 2 0

6 kungla kord 4 1 2

Summeeritud laial kujul tabeli saame praegu, kui kõikidest arvulistest tulpadest aritmeetiline keskmine võetakse ning lugude kaupa ridadesse paigutatakse.

> lai_tabel <- sonad %>% group_by(lugu) %>% summarise_if(is.numeric, mean)

> lai_tabel

# A tibble: 2 x 4

lugu sonapikkus taishaalikuid sulghaalikuid

<chr> <dbl> <dbl> <dbl>

1 kungla 4.76 2.27 0.68

2 lambipirn 5.89 2.67 1.32

Jooniste koostamiseks kasutatava ggplot'i tulpasid loov geom_col-käsklus eeldab, et saab andmestiku sisse tabeli pikal kujul - sõltumata joonisel olevast tulpade arvust on sisendtabelis ikka kolm tulpa: lugu, tunnus ja väärtus. Teisendamiseks sobib käsklus gather. Esimese parameetrina on sisse antud andmestik, teine ja kolmas uute tulpade nimed ning lõpus miinusmärgiga näidatu jääb sama tunnuse tulpasid eristama.

> pikk_tabel <- gather(lai_tabel, tunnus, vaartus, -lugu)

> pikk_tabel

# A tibble: 6 x 3

lugu tunnus vaartus

<chr> <chr> <dbl>

1 kungla sonapikkus 4.76

2 lambipirn sonapikkus 5.89

3 kungla taishaalikuid 2.27

4 lambipirn taishaalikuid 2.67

5 kungla sulghaalikuid 0.68

6 lambipirn sulghaalikuid 1.32

Pika tabeli põhjal luuakse ggplot-i tulpdiagramm. Tunnusest saab x-koordinaat ja väärtusest y-koordinaat. Täiendus position_dodge() määrab, et tulbad pannakse üksteise kõrvale.

pikk_tabel %>% ggplot(aes(tunnus, vaartus, fill=lugu)) + geom_col(position=position_dodge())

Kui näiteks ei võrreldaks keskmisi vaid üldarve, siis võib selle ära jätta ning tulba eri värvi osad pannakse üksteise peale. Siin sellise joonise koostamine etappide kaupa. Kõigepealt summa arvulistest tulpadest lugude kaupa.

> sonad %>% group_by(lugu) %>% summarise_if(is.numeric, sum)

# A tibble: 2 x 4

lugu sonapikkus taishaalikuid sulghaalikuid

<chr> <int> <int> <int>

1 kungla 357 170 51

2 lambipirn 3516 1592 788

Edasi joonis, kus vastavad tulbad üksteise peal, kummagi loo andmed ise värvi.

sonad %>%

group_by(lugu) %>%

summarise_if(is.numeric, sum) %>%

gather(tunnus, vaartus, -lugu) %>%

ggplot(aes(tunnus, vaartus, fill=lugu))+geom_col()

Lahendus

pikkused <- sonad %>%

group_by(lugu) %>%

summarise(suurim=max(sonapikkus),

keskmine=mean(sonapikkus),

mediaan=median(sonapikkus))

Andmete loetelu

head(pikkused)

lugu suurim keskmine mediaan

<chr> <dbl> <dbl> <int>

1 kungla 9 4.76 4

2 lambipirn 19 5.89 5

Andmed pikale kujule

> pikkused %>% gather(tunnus, tahti, -lugu)

# A tibble: 6 x 3

lugu tunnus tahti

<chr> <chr> <dbl>

1 kungla suurim 9

2 lambipirn suurim 19

3 kungla keskmine 4.76

4 lambipirn keskmine 5.89

5 kungla mediaan 4

6 lambipirn mediaan 5

Kõik korraga joonisele

pikkused %>%

gather(tunnus, tahti, -lugu) %>%

ggplot(aes(tunnus, tahti, fill=lugu)) + geom_col(position=position_dodge())

Andmeid haarata on lihtsam, kui need silme ette korraga ära mahuvad. Sellise olukorra tekitamiseks näide.

Kõigepealt koostame sagedusloendi sõnapikkuste kaupa:

> sonad %>% group_by(sonapikkus) %>% summarise(kogus=n())

# A tibble: 15 x 2

sonapikkus kogus

<int> <int>

1 2 82

2 3 64

3 4 98

4 5 112

5 6 92

6 7 61

7 8 54

8 9 40

9 10 26

10 11 13

11 12 15

12 13 7

13 14 4

14 15 3

15 19 1

Järgmise sammuna näitame kummagi loo sõnade pikkusi eraldi. Kõigepealt rühmitame read group_by abil ning pärast tehteid eemaldame rühmituse ungroup-iga

pikkused <-

sonad %>% group_by(lugu, sonapikkus) %>%

summarise(kogus=n()) %>% ungroup()

head(pikkused, 10)

lugu sonapikkus kogus

<chr> <int> <int>

1 kungla 2 9

2 kungla 3 8

3 kungla 4 21

4 kungla 5 12

5 kungla 6 14

6 kungla 7 5

7 kungla 8 2

8 kungla 9 4

9 lambipirn 2 73

10 lambipirn 3 56

Käsklus spread muudab tulemuse laiale kujule. Parameetrina sõnapikkuse väärtustest saavad tulpade nimed ning kogusest tuleb tabeli lahtrite sisu. Tulba "lugu" eraldi väärtustest saavad uue loodava tabeli read.

> spread(pikkused, sonapikkus, kogus)

# A tibble: 2 x 16

lugu `2` `3` `4` `5` `6` `7`

<ch> <int> <int> <int> <int> <int> <int>

1 kun~ 9 8 21 12 14 5

2 lam~ 73 56 77 100 78 56

# ... with 9 more variables: `8` <int>,

Mugavama vaatamiskuju annab käsklus View. Puuduvate andmete kohale nullide kirjutamise määrab parameeter fill=0, Kungla rahva juures lihtsalt pole kümnest tähest pikemaid sõnu.

> View(spread(pikkused, sonapikkus, kogus, fill=0))

Mõõtmisel saadakse kätte hulk tulemusi, mis näitavad arve otseselt mõõdetud objektide kohta ning need sobivad kindlasti nende samade objektide ja seisu kirjeldamiseks. Kuivõrd on võimalik kätte saadud tulemusi üldistada laiemaks kasutamiseks, see on juba keerulisem ning selle tarbeks on andmeanalüüsivaldkonnas kokku pandud hulk teste. R-keeles lihtsamaks neist on prop.test ehk proportsioonide test.

Pakett mällu ning andmed muutujasse.

library(tidyverse)

sonad=read_csv("http://www.tlu.ee/~jaagup/andmed/keel/kunglarahvas_lambipirn_pikkused_haalikud.txt")

Andmestikust juhuslikult valitud kümne sõna andmed sample_n käsu abil

> sample_n(sonad, 10)

# A tibble: 10 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 lambipirn hotellitoas 11 5 2

2 lambipirn see 3 2 0

3 lambipirn ilmselt 7 2 1

4 lambipirn võimalik 8 4 1

5 lambipirn keerab 6 3 2

6 lambipirn ka 2 1 1

7 kungla ja 2 1 0

8 lambipirn sedakorda 9 4 3

9 lambipirn on 2 1 0

10 lambipirn kahe 4 2 1

Uuel käivitamisel tulevad sootuks teised sõnad

> sample_n(sonad, 10)

# A tibble: 10 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla rahvas 6 2 0

2 lambipirn kirurgi 7 3 2

3 lambipirn pirni 5 2 1

4 lambipirn funktsioneeriva 15 7 2

5 lambipirn valgusallikata 14 6 3

6 lambipirn joodud 6 3 2

7 lambipirn tõene 5 3 1

8 lambipirn toolile 7 4 1

9 lambipirn käigus 6 3 2

10 kungla siis 4 2 0

Ja kolmandal korral hoopis midagi muud. Kusjuures paistab, et esimesel korral oli üks sõna kümnest Kungla rahva loost, teisel kaks ning kolmandal mitte ühtegi. Kuna kõigil kordadel valiti juhuslikud read, siis nii ühe, kahe kui ka kolme Kungla rahva sõna esinemine kümnest sõnast on täiesti loomulik, kui peaksime püüdma juhuslikult leitud sõnade põhjal püüdma hinnata sõnade sageduste suhet üldkogumis ehk mõlema täisteksti kogumis.

> sample_n(sonad, 10)

# A tibble: 10 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 lambipirn ta 2 1 1

2 lambipirn ei 2 2 0

3 lambipirn siis 4 2 0

4 lambipirn ja 2 1 0

5 lambipirn ole 3 2 0

6 lambipirn politseinikud 13 6 4

7 lambipirn traumapunkti 12 5 4

8 lambipirn õrnalt 6 2 1

9 lambipirn sest 4 1 1

10 lambipirn traumapunkti 12 5 4

Ainult arvude kätte saamiseks rühmitame sõnad loo järgi ja loemegi kohe esinemiskordade arvud. Nagu paistab, siis võib tulla ette ka olukord, kus mõlemaid on ühepalju

> sample_n(sonad, 10) %>% group_by(lugu) %>% summarise(kogus=n())

# A tibble: 2 x 2

lugu kogus

<chr> <int>

1 kungla 5

2 lambipirn 5

Kungla rahva omi on kümnendik

> sample_n(sonad, 10) %>% group_by(lugu) %>% summarise(kogus=n())

# A tibble: 2 x 2

lugu kogus

<chr> <int>

1 kungla 1

2 lambipirn 9

või puuduvad nad sootuks.

> sample_n(sonad, 10) %>% group_by(lugu) %>% summarise(kogus=n())

# A tibble: 1 x 2

lugu kogus

<chr> <int>

1 lambipirn 10

Arve saja kaupa küsides kõiguvad tulemused suhtarvuna veidi vähem, absoluutarvuna aga ikka märkimisväärselt : sajast 14, 10 ja 8 esinemiskorda.

> sample_n(sonad, 100) %>% group_by(lugu) %>% summarise(kogus=n())

# A tibble: 2 x 2

lugu kogus

<chr> <int>

1 kungla 14

2 lambipirn 86

> sample_n(sonad, 100) %>% group_by(lugu) %>% summarise(kogus=n())

# A tibble: 2 x 2

lugu kogus

<chr> <int>

1 kungla 10

2 lambipirn 90

> sample_n(sonad, 100) %>% group_by(lugu) %>% summarise(kogus=n())

# A tibble: 2 x 2

lugu kogus

<chr> <int>

1 kungla 8

2 lambipirn 92

Võib ka küsida sada juhuslikku sõna ning siis filtreerida loo järgi välja ja küsida koguarv.

> sample_n(sonad, 100) %>% filter(lugu=="kungla") %>% count()

# A tibble: 1 x 1

n

<int>

1 15

> sample_n(sonad, 100) %>% filter(lugu=="kungla") %>% count()

# A tibble: 1 x 1

n

<int>

1 10

Uuringutes küllalt sageli ongi nii, et meil on võimalik mõõta mingi osa objekte ning saadud tulemuste põhjal tuleb teha võimalikult hea ehk siis arusaadavate usalduspiiridega järeldus kõigi sarnaste objektide peale. R-is käsklus ühe osakomponendi suhtarvupiiride leidmisks käsklus prop.test - jälgime, mida vastusest välja lugeda võib. Näitena olukord, kus Kungla rahva sõnu oli sajast valitud sõnast 15.

> prop.test(15, 100)

1-sample proportions test with continuity correction

data: 15 out of 100, null probability 0.5

X-squared = 47.61, df = 1, p-value = 5.2e-12

alternative hypothesis: true p is not equal to 0.5

95 percent confidence interval:

0.0891491 0.2385308

sample estimates:

p

0.15

Esialgu on saadud vastusest tähtsaim lause: "95% tõenäosusega võime väita, et nähtud andmete põhjal jääb Kungla rahva sõnade osakaal kõigis uuritud sõnadest 8,9% kuni 23,9% vahele.

Samuti võrreldakse andmeid nullhüpoteesiga (kahes tekstis on võrdselt sõnu) ning teatatakse, et selle kehtivuse tõenäosus on 5.2e-12, ehk siis 0,0000000000052 - mis on sama vähe tõenäoline, kui peidetud liivatera esimesel katsel leidmine tuhande kuupmeetri liiva seest.

Teisel katsel leitud kümme sõna sajast seab Kungla rahva sõnade eeldatavaks osakaaluks 0,05 kuni 0,18. Nagu näha, siis vahemik mõnevõrra kõigub, aga 8 kuni 18 protsenti on mõlema katse puhul ennustatava vahemiku sees.

> prop.test(10, 100)

1-sample proportions test with continuity correction

data: 10 out of 100, null probability 0.5

X-squared = 62.41, df = 1, p-value = 2.789e-15

alternative hypothesis: true p is not equal to 0.5

95 percent confidence interval:

0.0516301 0.1803577

sample estimates:

p

0.1

Kui katsel juhtus tulema kaheksa sõna sajast,

> prop.test(8, 100)

95 percent confidence interval:

0.03767874 0.15614533

siis eeldatav vahemik läks nelja ja 16 protsendi vahele.

Sõltuvalt uuringu tulemuste mõjust vajatakse eri täpsusega hinnanguid. Päris täpse tulemuse saame vaid siis, kui kõik sõnad kummaski tekstis üle loeme. Kui see aga mingil põhjusel jõukohane pole ja oleme valmis leppima vale hinnanguga ühel juhul sajast, siis võime sättida usaldusnivoo (conf.level) 99% peale ja vaadata, millist usaldusintervalli ehk -vahemikku meile pakutakse.

> prop.test(8, 100, conf.level=0.99)

99 percent confidence interval:

0.03062124 0.18502380

Võrdlusena - eelnevalt 95% juures oli vahemik 0.03767874 0.15614533 - ehk siis mõnevõrra kitsam. Nii ka teiste mõõtmiste puhul - lihtsalt vahemik ise veidi teises kohas:

> prop.test(15, 100, conf.level=0.99)

99 percent confidence interval:

0.07652508 0.26925703

Ka väiksem katsete arv laiendab intervalli - ning suurem vastupidi kahandab. Näiteks kui tuleb ühel korral kümnest sõna "Kungla rahvast", siis selle järgi võin 99% tõenäosusega väita vaid, et Kungla rahva sõnu on kõikide sõnade hulgas 0,3 kuni 55 protsenti.

> prop.test(1, 10, conf.level=0.99)

99 percent confidence interval:

0.003298139 0.554819141

Kui sõnu on kümme sajast, siis piisab sellest 99% tõenäosusega väitmiseks, et sõnade osakaal on 4 kuni 21 protsenti

> prop.test(10, 100, conf.level=0.99)

99 percent confidence interval:

0.04284027 0.20989670

Seni mängisime andmetega pimesikku. Siin näites aga meil üldkogum olemas ning võimalik ka tegelik vastus kätte saada. Kungla rahva sõnade suhtarv on:

> sonad %>% filter(lugu=="kungla") %>% count() / nrow(sonad)

n

1 0.1116071

Mõlema loo sõnade üldarv:

> sonad %>% group_by(lugu) %>% summarise(kogus=n())

# A tibble: 2 x 2

lugu kogus

<chr> <int>

1 kungla 75

2 lambipirn 597

Kui teha katseid suuremate arvudega, siis tulevad need juba leitud suhte lähedale. Kui sample_n käsu puhul lisada parameeter replace=TRUE, siis lubatakse kord võetud ridu ka hiljem kuvada.

> sample_n(sonad, 1000, replace=TRUE) %>% filter(lugu=="kungla") %>% count()

# A tibble: 1 x 1

n

<int>

1 123

> sample_n(sonad, 10000, replace=TRUE) %>% filter(lugu=="kungla") %>% count()

# A tibble: 1 x 1

n

<int>

1 1129

Kui katsete tulemusena saadud, et 1129 rida kümnest tuhandest on mingit tüüpi, siis sealtkaudu läheb usaldusvahemik juba võrreldes eelmistega päris kitsaks kokku ning nagu nüüd meile teada olevate andmetega võrrelda saab, siis näitab ka õigesti.

> prop.test(1129, 10000)

95 percent confidence interval:

0.1067966 0.1193031

Test võimaldab katsete põhjal leitud suhet võrrelda varem arvutatud suhtega ning näidata, kui tõenäoline on, et andmed võiksid olla samast üldkogumist ehk "ühisest potist". Leiame Lambipirni jutus viietäheliste ja pikemate sõnade osakaalu:

sonad %>% filter(lugu=="lambipirn" & sonapikkus>=5) %>% count() /

sonad %>% filter(lugu=="lambipirn") %>% count()

n

1 0.6549414

Leiame Kungla rahva loos vähemalt viietähelised sõnad ning sõnade üldarvu.

> sonad %>% filter(lugu=="kungla" & sonapikkus>=5) %>% count()

# A tibble: 1 x 1

n

<int>

1 37

> sonad %>% filter(lugu=="kungla") %>% count()

# A tibble: 1 x 1

n

<int>

1 75

Nüüd võrdleme andmeid omavahel.

> prop.test(37, 75, p=0.65)

1-sample proportions test with continuity correction

data: 37 out of 75, null probability 0.65

X-squared = 7.4176, df = 1, p-value = 0.006459

alternative hypothesis: true p is not equal to 0.65

95 percent confidence interval:

0.3769863 0.6103674

sample estimates:

p

0.4933333

Püüame tulemuse inimkeeli kirja panna. Võrdleme Kungla rahva pikkade sõnade suhet 37 75st (mille puhul me ei eelda, et kõik sõnad on teada) Lambipirni jutu eelnevalt teadaoleva 0.65-ga. Üleval näidatud p-väärtus 0.006459 tähendab, et tõenäosus, et sõnade pikkus ei sõltu loost on vaid 0,65%. 99,35% tõenäosusega on järelikult seos olemas. Kui meil on teada 37 sõna kohta 75st, et nood on vähemasti viie tähe pikkused, siis selle põhjal saab 95% tõenäosusega väita, et uuritava teksti vähemalt 5-täheliste sõnade osa on 38% kuni 61%.

Eri katsetel saadud vahemikke võib olla vahel kasulik illustreerimiseks kuvada joonisel. Selleks loome kõigepealt mõned andmed ja siis kuvame. Kõigepealt meeldetuletus katsest, kus väljundiks oli kümme Kungla rahva sõna saja sõna peale kokku. Käsk prop.test väljastas selle peale, et sõnade esinemissagedus üldkogumis võiks olla 5% kuni 18%

> prop.test(10, 100)

1-sample proportions test with continuity correction

data: 10 out of 100, null probability 0.5

X-squared = 62.41, df = 1, p-value = 2.789e-15

alternative hypothesis: true p is not equal to 0.5

95 percent confidence interval:

0.0516301 0.1803577

sample estimates:

p

0.1

Andmete mugavamaks sisestamiseks joonisekäsklusesse koostame neist koordinaatide üherealise tabeli

koordinaadid=tibble(x1=0.051, y1=0, x2=0.18, y2=0)

Käsuga geom_curve tõmbame nende kahe punkti vahele kõverjoone

ggplot() + xlim(0, 1) +

geom_curve(aes(x=x1, y=y1, xend=x2, yend=y2),

data=koordinaadid)

Sama katse kohta, kus saadi 15 Kungla rahva sõna sajast

> prop.test(15, 100)

95 percent confidence interval:

0.0891491 0.2385308

Tabelisse paneme mõlemad väärtused koos. Kõigepealt esimene ning siis add_row käsu abil teine juurde

koordinaadid=tibble(x1=0.051, y1=0, x2=0.18, y2=0)

koordinaadid <- koordinaadid %>% add_row(x1=0.089, y1=0, x2=0.23, y2=0)

koordinaadid

# A tibble: 2 x 4

x1 y1 x2 y2

<dbl> <dbl> <dbl> <dbl>

1 0.051 0 0.18 0

2 0.089 0 0.23 0

ggplot suudab mõlema rea põhjal kaared joonistada, xlim(0, 1) näitab x-telje ulatust joonisel.

> ggplot() + xlim(0, 1) +

+ geom_curve(aes(x=x1, y=y1, xend=x2, yend=y2),

+ data=koordinaadid)

Üksikud väärtused kannatab ekraanilt lugeda ning sinna sobivatesse kohtadesse tagasi toksida. R võimaldab testide väljundid ka muutujate kaudu kätte saada ning nii on võimalik neid otse edasi toimetada ja sealtkaudu lasta arvutil hulga arvutusi järgemööda ette võtta. Testi pakutava vahemiku alumise ja ülemise piiri saab kätte conf.int-muutuja kaudu

> prop.test(10, 100)$conf.int[1]

[1] 0.0516301

> prop.test(10, 100)$conf.int[2]

[1] 0.1803577

Lihtsalt ridade arvu küsides annab count-käsklus vastuseks tabeli, kus on üks tulp nimega n ning selle sees on üks rida saadud väärtusega.

> sonad %>% sample_n(100) %>% filter(lugu=="kungla") %>% count()

# A tibble: 1 × 1

n

<int>

1 9

Valemisse on aga ainult seda arvu vaja, mitte tervet tabelit. Väärtuse küsimiseks tuleb käsuahelale lisada veel üks etapp - punkt tähistab jooksvat andmestikku ning sellele järgnev dollar ja täht tulpa, millest soovitakse väärtus saada. Nii tulebki soovitud arv otse esile.

> sonad %>% sample_n(100) %>% filter(lugu=="kungla") %>% count() %>% .$n

[1] 6

Juhuslike ridade valimise tõttu sample_n käsus on uuel käivitamisel tulemus midagi muud

> sonad %>% sample_n(100) %>% filter(lugu=="kungla") %>% count() %>% .$n

[1] 14

Saadud arvu saab prop.test-käsus juba sobivale kohale paigutada.

> prop.test(sonad %>% sample_n(100) %>% filter(lugu=="kungla") %>% count() %>% .$n, 100)

1-sample proportions test with continuity correction

data: sonad %>% sample_n(100) %>% filter(lugu == "kungla") %>% count() %>% out of 100, null probability 0.5 .$n out of 100, null probability 0.5

X-squared = 68.89, df = 1, p-value < 2.2e-16

alternative hypothesis: true p is not equal to 0.5

95 percent confidence interval:

0.03767874 0.15614533

sample estimates:

p

0.08

Või siis muutujasse lugeda ning sealt juba vastuste tabeli kaudu joonisele paigutada.

testivastus <- prop.test(sonad %>% sample_n(100) %>%

filter(lugu=="kungla") %>% count() %>% .$n,

100)

koordinaadid=tibble(x1=testivastus$conf.int[1], y1=0, x2=testivastus$conf.int[2], y2=0)

koordinaadid

ggplot() + xlim(0, 1) +

geom_curve(aes(x=x1, y=y1, xend=x2, yend=y2),

data=koordinaadid)

Vastusena näha kinni püütud koordinaadid

# A tibble: 1 x 4

x1 y1 x2 y2

<dbl> <dbl> <dbl> <dbl>

1 0.0377 0 0.156 0

ning neile vastav joonis

Soovitud arvuloetelu saab, kui arvude ja kooloni abil ette anda vahemik

> 1:5

[1] 1 2 3 4 5

Nõnda palju kordi mõnd tegevust korrata kannatab for-tsükliga. Praegusel juhul kuvatakse vastavate arvude ruudud

for(x in 1:5){

print(x*x)

}

[1] 1

[1] 4

[1] 9

[1] 16

[1] 25

Ühed ees, sest igal korral tuleb uus eraldi üheelemendiline vastus.

R-keeles on kordustega toimetamiseks lisaks tsüklitele olemas apply-perekonna funktsioonid, suhteliselt lihtsasti kasutatav neist sapply.

sapply(1:5, function(x){

sonad %>% sample_n(100) %>%

filter(lugu=="kungla") %>% count() %>% .$n

})

[1] 10 10 7 17 17

Uuel käivitamisel salvestame arvud eraldi muutujasse kunglakogused ning vaatame selle väärtust

kunglakogused <- sapply(1:5, function(x){

sonad %>% sample_n(100) %>%

filter(lugu=="kungla") %>% count() %>% .$n

})

kunglakogused

[1] 12 13 8 12 7

Nüüdse kordusega teeme iga leitud koguse peale prop.test-i ja testivastusteks x1 ja x2 kohale paigutame leitud usaldusintervalli alam- ja ülempiiri

testivastused=sapply(kunglakogused, function(kogus){

pt=prop.test(kogus, 100)

c(x1=pt$conf.int[1], y1=0, x2=pt$conf.int[2], y2=0)

})

testivastused

> testivastused

[,1] [,2] [,3] [,4] [,5]

x1 0.06625153 0.07376794 0.03767874 0.06625153 0.03101985

y1 0.00000000 0.00000000 0.00000000 0.00000000 0.00000000

x2 0.20397718 0.21560134 0.15614533 0.20397718 0.14376573

y2 0.00000000 0.00000000 0.00000000 0.00000000 0.00000000

Joonise mugavamaks koostamiseks vahetame read ja veerud

> t(testivastused)

x1 y1 x2 y2

[1,] 0.06625153 0 0.2039772 0

[2,] 0.07376794 0 0.2156013 0

[3,] 0.03767874 0 0.1561453 0

[4,] 0.06625153 0 0.2039772 0

[5,] 0.03101985 0 0.1437657 0

ning muudame uuemale tibble-kujule

> as_tibble(t(testivastused))

# A tibble: 5 x 4

x1 y1 x2 y2

<dbl> <dbl> <dbl> <dbl>

1 0.0663 0 0.204 0

2 0.0738 0 0.216 0

3 0.0377 0 0.156 0

4 0.0663 0 0.204 0

5 0.0310 0 0.144 0

Edasi saame sealt ggplot-i ja selle sees kõverjoone loova geom_curve abil kaared joonisele kätte

ggplot() + xlim(0, 1) +

geom_curve(aes(x=x1, y=y1, xend=x2, yend=y2),

data=as_tibble(t(testivastused)))

Sama arvutus üldisemal kujul, kus yldarv tähendab, et mitu juhuslikku sõna kogumist võetakse ning katsete arv, et mitu korda vastavat katset korratakse. Taas loetakse iga katse korral, et mitu sõna oli Kungla rahvast ning joonistatakse välja selle põhjal kättesaadavad üldistuspiirid

yldarv <- 50

katsetearv <- 20

kunglakogused <- sapply(1:katsetearv, function(x){

sonad %>% sample_n(yldarv) %>%

filter(lugu=="kungla") %>% count() %>% .$n

})

testivastused <- sapply(kunglakogused, function(kogus){

pt=prop.test(kogus, yldarv)

c(x1=pt$conf.int[1], y1=0, x2=pt$conf.int[2], y2=0)

})

ggplot() + xlim(0, 0.5) +

geom_curve(aes(x=x1, y=y1, xend=x2, yend=y2),

data=as_tibble(t(testivastused)))

kunglakogused

[1] 6 2 4 8 5 6 3 7 6 8 7 5 4 4 8 5 2 4 9 2

yldarv <- 50

katsetearv <- 10

loonimi <- "lambipirn"

lookogused <- sapply(1:katsetearv, function(x){

sonad %>% sample_n(yldarv) %>%

filter(lugu==loonimi) %>% count() %>% .$n

})

testivastused <- sapply(lookogused, function(kogus){

pt=prop.test(kogus, yldarv)

c(x1=pt$conf.int[1], y1=0, x2=pt$conf.int[2], y2=0)

})

ggplot() + xlim(0, 1.0) +

geom_curve(aes(x=x1, y=y1, xend=x2, yend=y2),

data=as_tibble(t(testivastused)))+

ggtitle(loonimi) +

xlab("sagedusvahemik") + ylab("") +

theme(axis.text.y=element_blank())

lookogused

[1] 45 45 48 45 42 43 48 43 44 44

Märkimisväärne hulk uuringuid jõuab andmete esitamise juures 2x2 tabelini. Siin näites kaks lugu ning loendamine, et kui palju on vähemalt viietähelisi sõnu ning kui palju sellest lühemaid.

sonapikkused <- sonad %>% group_by(lugu) %>%

summarise(

lyhikesi=sum(sonapikkus<5),

pikki=sum(sonapikkus>=5)

) %>% ungroup()

> sonapikkused

# A tibble: 2 x 3

lugu lyhikesi pikki

<chr> <int> <int>

1 kungla 38 37

2 lambipirn 206 391

Testi saab teha vaid arvulistele tunnustele, nii eemaldame tabelist loo nimed

> sonapikkused %>% select(-lugu)

# A tibble: 2 x 2

lyhikesi pikki

<int> <int>

1 38 37

2 206 391

ja teisendame prop.test käsu jaoks sobilikule maatriksi kujule

> sonapikkused %>% select(-lugu) %>% as.matrix()

lyhikesi pikki

[1,] 38 37

[2,] 206 391

Test ise:

> prop.test(sonapikkused %>% select(-lugu) %>% as.matrix())

2-sample test for equality of proportions with continuity

correction

data: sonapikkused %>% select(-lugu) %>% as.matrix()

X-squared = 6.8422, df = 1, p-value = 0.008903

alternative hypothesis: two.sided

95 percent confidence interval:

0.03470217 0.28851392

sample estimates:

prop 1 prop 2

0.5066667 0.3450586

Seletus:

> matrix(nrow=2, ncol=2, c(20, 10, 80, 290))

[,1] [,2]

[1,] 20 80

[2,] 10 290

> prop.test(matrix(nrow=2, ncol=2, c(20, 10, 80, 290)))

2-sample test for equality of proportions with continuity correction

data: matrix(nrow = 2, ncol = 2, c(20, 10, 80, 290))

X-squared = 27.676, df = 1, p-value = 1.435e-07

alternative hypothesis: two.sided

95 percent confidence interval:

0.07901275 0.25432059

sample estimates:

prop 1 prop 2

0.20000000 0.03333333

> prop.test(matrix(nrow=2, ncol=2, c(20, 10, 80, 40)))

2-sample test for equality of proportions without continuity correction

data: matrix(nrow = 2, ncol = 2, c(20, 10, 80, 40))

X-squared = 0, df = 1, p-value = 1

alternative hypothesis: two.sided

95 percent confidence interval:

-0.1357903 0.1357903

sample estimates:

prop 1 prop 2

0.2 0.2

Siin on kolmel korral mõõdetud, mitu otsitavat (nt. Kungla rahva sõna) leiti saja objekti (sõna) hulgast. Leiti vastavalt katsele 8, 10 ja 15 korda. Käsu prop.test väljund näitab, et tõenäosus, et mõõdeti sisaldust samasugusest valimist on 26,5% (aga praegu oligi sama andmestik). Alles siis, kui p läheks alla 0.05 või 0.01 või mõne muu olulisusnivooks võetud suhte, võiksime hakata väitma, et sagedused rühmiti erinevad.

> prop.test(c(8, 10, 15), c(100, 100, 100))

3-sample test for equality of proportions without continuity

correction

data: c(8, 10, 15) out of c(100, 100, 100)

X-squared = 2.6558, df = 2, p-value = 0.265

alternative hypothesis: two.sided

sample estimates:

prop 1 prop 2 prop 3

0.08 0.10 0.15

Järgmises näites võtame (Kungla rahva) sõnad kümne kaupa rühmadesse ja koostame nõnda laulu esimesest viiekümnest sõnast viis rühma, kus arvutame sõnapikkuste ning sulghäälikute arvu summad.

kogused <- sonad %>% mutate(ryhm=floor(row_number()/10)) %>%

filter(ryhm<5) %>% group_by(ryhm) %>%

summarise(pikkus=sum(sonapikkus), sulgh=sum(sulghaalikuid))

kogused

> kogused

# A tibble: 5 x 3

ryhm pikkus sulgh

<dbl> <int> <int>

1 0 43 8

2 1 52 7

3 2 51 9

4 3 42 3

5 4 51 8

Nii saab kogused eraldi välja küsida, nagu näha, siis pikkuste summad on rühmas erinevad

> kogused$sulgh

[1] 8 7 9 3 8

> kogused$pikkus

[1] 43 52 51 42 51

Testi tulemus ütleb, et tõenäosus, et valimid on samast üldkogumist on 0,5746, ehk siis pole põhjust kahtlustama hakata, et laulu tagumistes lõikudes sulghäälikute osakaal oluliselt erineks esimeste lõikude omadest.

> prop.test(kogused$sulgh, kogused$pikkus)

5-sample test for equality of proportions without continuity

correction

data: kogused$sulgh out of kogused$pikkus

X-squared = 2.9007, df = 4, p-value = 0.5746

alternative hypothesis: two.sided

sample estimates:

prop 1 prop 2 prop 3 prop 4 prop 5

0.18604651 0.13461538 0.17647059 0.07142857 0.15686275

Eelnenud proportsioonide testiga enamvähem sarnaselt kasutatakse hii-ruut testi, õigemini prop.test-i saab pidada chisq.test-i erijuhtumiks, kus korraga mõõdetakse vaid kahte arvu või tulpa. Hii-ruut testil selliseid piiranguid pole. Alustuseks sissejuhatav väljamõeldud näide õunte peal.

Tabel selle kohta, milliseid õunu millisel päeval kui palju korjati

> ounad=read_csv("http://www.tlu.ee/~jaagup/andmed/muu/ounad/ounad_paevad_2.txt")

> ounad

# A tibble: 3 x 3

ounasort esmaspaev reede

<chr> <int> <int>

1 Antoonovka 80 40

2 Valge klaar 60 30

3 Liivika 100 50

Testi tulemus:

> ounad %>% select(-ounasort) %>% chisq.test()

Pearson's Chi-squared test

data: .

X-squared = 0, df = 2, p-value = 1

Kuna reedel korjati esmaspäevast lihtsalt poole vähem õunu, aga suhted õunasortide vahel jäid samaks, siis tõenäosus, et korjati sarnaselt ehk nullhüpoteesi tõenäosus on 100% - ehk siis pole põhjust kahtlustada erinevat korjamist eri päevadel.

Teises täites korjati reedel esmaspäevast tunduvalt vähem Antoonovkaid ja rohkem Valgeid klaare, selle peale teatab ka test, et korje päevadel on erinev, ehk siis tõenäosus, et korjati ühtmoodi ja kogemata tulid sellised väärtused on 10 astmel -16.

> ounad=read_csv("http://www.tlu.ee/~jaagup/andmed/muu/ounad/ounad_paevad_1.txt")

> ounad

# A tibble: 3 x 3

ounasort esmaspaev reede

<chr> <int> <int>

1 Antoonovka 80 10

2 Valge klaar 60 200

3 Liivika 100 100

> ounad %>% select(-ounasort) %>% chisq.test()

Pearson's Chi-squared test

data: .

X-squared = 122.91, df = 2, p-value < 2.2e-16

Sõnade sagedused vastavalt pikkusele

Sisendiks kolme teksti sõnad

sonad=read_csv("http://www.tlu.ee/~jaagup/andmed/keel/kunglarahvas_lambipirn_hinnad_pikkused_haalikud.txt")

Vastavalt loole loeme kokku, kui palju kusagil on kolme tähe pikkusi sõnu

> sonad %>% filter(sonapikkus==3) %>% group_by(lugu) %>% summarise(kogus=n())

# A tibble: 3 x 2

lugu kogus

<chr> <int>

1 hinnad 31

2 kungla 8

3 lambipirn 56

Võrdluseks juurde ka viie tähe pikkused sõnad

> sonad %>% filter(sonapikkus %in% c(3, 5)) %>% group_by(lugu, sonapikkus) %>% summarise(kogus=n())

# A tibble: 6 x 3

# Groups: lugu [?]

lugu sonapikkus kogus

<chr> <int> <int>

1 hinnad 3 31

2 hinnad 5 25

3 kungla 3 8

4 kungla 5 12

5 lambipirn 3 56

6 lambipirn 5 100

Tulemus spread-käsu abil laia tabelisse

> sonad %>% filter(sonapikkus %in% c(3, 5)) %>% group_by(lugu, sonapikkus) %>%

+ summarise(kogus=n()) %>% ungroup() %>% spread(sonapikkus, kogus)

# A tibble: 3 x 3

lugu `3` `5`

<chr> <int> <int>

1 hinnad 31 25

2 kungla 8 12

3 lambipirn 56 100

Siia otsa saab juba hii-ruut testi rakendada. Enne eemaldades loo nime kui sõnalise tunnuse.

sonad %>% filter(sonapikkus %in% c(3, 5)) %>% group_by(lugu, sonapikkus) %>%

summarise(kogus=n()) %>% ungroup() %>% spread(sonapikkus, kogus) %>%

select(-lugu) %>% chisq.test()

Tulemuseks tõenäosus lugude ühesuguste sõnapikkuste kohta 4%, ehk siis 96% tõenäosusega võime võita, et kolme- ja viietäheliste sõnade sagedus lugudes on erinev.

Pearson's Chi-squared test

data: .

X-squared = 6.4614, df = 2, p-value = 0.03953

Harjutuses siis esimest korda olukord, kus tulpasid rohkem kui kaks - ehk prop.test-i käsklusest ei piisaks. Mugavamaks vaatamiseks sõnapikkuse tulbale p-täht ette, nii ei teki hiljem arvulisi tulbanimesid, mille käsitsemine veidi tülikam

sonad %>% filter(sonapikkus %in% c(3, 5, 10)) %>% group_by(lugu, sonapikkus) %>%

summarise(kogus=n()) %>% ungroup() %>% mutate(sonapikkus=paste("p",sonapikkus, sep=""))

# A tibble: 8 x 3

lugu sonapikkus kogus

<chr> <chr> <int>

1 hinnad p3 31

2 hinnad p5 25

3 hinnad p10 11

4 kungla p3 8

5 kungla p5 12

6 lambipirn p3 56

7 lambipirn p5 100

8 lambipirn p10 26

Andmed laia tabelisse

sonad %>% filter(sonapikkus %in% c(3, 5, 10)) %>% group_by(lugu, sonapikkus) %>%

summarise(kogus=n()) %>% ungroup() %>% mutate(sonapikkus=paste("p",sonapikkus, sep="")) %>%

spread(sonapikkus, kogus, fill=0)

lugu p10 p3 p5

<chr> <dbl> <dbl> <dbl>

1 hinnad 11 31 25

2 kungla 0 8 12

3 lambipirn 26 56 100

Hii-ruut testi tulemus

sonad %>% filter(sonapikkus %in% c(3, 5, 10)) %>% group_by(lugu, sonapikkus) %>%

summarise(kogus=n()) %>% ungroup() %>% mutate(sonapikkus=paste("p",sonapikkus, sep="")) %>%

spread(sonapikkus, kogus, fill=0) %>% select(-lugu) %>% chisq.test()

Pearson's Chi-squared test

data: .

X-squared = 9.9375, df = 4, p-value = 0.04149

Paistab, et kaasates ka 10 tähe pikkused sõnad võib endiselt ligikaudu 96% tõenäosusega väita, et sõnade pikkused lugudes on erinevad.

Aritmeetiliste keskmiste võrdlemine

Ühekordse arvutusena saame vastuse parajasti kättesaadavate andmete põhjal. Kui mõõdetakse mitmel korral ja (suhteliselt) juhuslikult kättesaadavate andmetega, siis hakkab aritmeetiline keskmine mõnevõrra kõikuma katsete vahel. Järgnevas näiteks Kungla rahva kümne juhusliku sõna pikkuste aritmeetiline keskmine

> sonad %>% filter(lugu=="kungla") %>% sample_n(10) %>% summarise(k=mean(sonapikkus))

# A tibble: 1 x 1

k

<dbl>

1 4.1

> sonad %>% filter(lugu=="kungla") %>% sample_n(10) %>% summarise(k=mean(sonapikkus))

# A tibble: 1 x 1

k

<dbl>

1 4.9

> sonad %>% filter(lugu=="kungla") %>% sample_n(10) %>% summarise(k=mean(sonapikkus))

# A tibble: 1 x 1

k

<dbl>

1 4.5

Nagu näha, siis siin tuli vastuseks igal korral tabel, millel üks rida ja üks veerg. Palja väärtuse jaoks tuleb see sealt eraldi dollari ja veerunime järgi välja küsida.

> sonad %>% filter(lugu=="kungla") %>% sample_n(10) %>% summarise(k=mean(sonapikkus)) %>% .$k

[1] 4.3

Tahtes väärtusi suuremas koguses leida, aitab meid eelnevalt tuttav funktsioon sapply. Esialgu kümme katset

sapply(1:10, function(x){

sonad %>% filter(lugu=="kungla") %>% sample_n(10) %>% summarise(k=mean(sonapikkus)) %>% .$k

})

[1] 5.4 4.3 4.6 3.7 4.3 4.3 6.0 5.8 4.4 4.3

Suurema pildi jaoks sada

kungla_sonapikkused <- sapply(1:100, function(x){

sonad %>% filter(lugu=="kungla") %>% sample_n(10) %>% summarise(k=mean(sonapikkus)) %>% .$k

})

kungla_sonapikkused

[1] 5.2 4.7 4.7 3.8 4.9 5.3 5.0 4.6 4.7 4.8 4.9 4.9 5.6 5.1 5.2 4.9 5.3 5.9 4.5 5.0 5.3 4.3 4.3

[24] 5.1 5.2 5.0 5.7 4.5 4.5 4.8 4.0 4.6 5.3 5.2 5.2 4.2 4.4 5.3 4.6 4.5 4.7 3.5 4.5 3.5 4.7 5.0

[47] 5.7 4.6 5.2 3.8 5.2 4.9 4.5 4.6 4.7 4.2 4.0 4.6 3.9 4.7 4.3 4.8 4.6 4.2 4.5 4.6 4.2 3.6 4.7

[70] 4.9 4.0 4.5 5.3 4.5 5.2 4.8 5.3 4.5 4.9 5.0 4.9 4.9 5.1 4.8 4.7 4.9 4.7 4.7 5.1 4.5 4.3 4.8

[93] 4.2 4.2 4.7 4.8 5.3 4.4 4.7 4.5

Andmete jaotusest ülevaate saamiseks historamm kümne kaupa võetud sõnade pikkuste keskmiste kohta

hist(kungla_sonapikkused)

Käskluse teist korda käivitamine annab mõnevõrra teravama keskmise tipuga jaotuse

Kolmandal korral kaldub tulemuste haripunkt sootuks veidi vasakule

Et kõigil juhtudel võti juhuslikud sõnad, siis saab kõiki neid jaotusi loomulikuks pidada. Lisaks ühtlasi näitavad välja, et katse ühel korral saadud tulemus võib teisel juhul vähemalt siin nähtud piirides erineda ilma, et sellest midagi üleloomulikku oleks.

lambipirn_sonapikkused <- sapply(1:100, function(x){

sonad %>% filter(lugu=="lambipirn") %>% sample_n(10) %>% summarise(k=mean(sonapikkus)) %>% .$k

})

lambipirn_sonapikkused

[1] 5.3 6.4 5.3 5.4 7.6 5.4 5.6 7.2 4.9 4.9 6.8 4.0 5.5 6.3 6.3 7.3 5.1 5.3 6.0 6.1 5.2 4.9 5.8

[24] 5.4 4.8 7.9 4.1 4.1 5.4 4.6 4.5 6.2 5.7 4.9 6.3 4.6 6.7 6.8 5.2 4.8 6.7 5.9 7.3 4.9 5.6 6.5

[47] 5.8 6.4 5.8 4.7 7.5 5.4 6.1 5.4 5.6 6.3 5.8 5.0 5.7 6.5 6.0 6.8 4.6 6.1 4.4 5.1 5.9 6.8 4.7

[70] 5.1 4.7 5.1 6.2 4.5 5.4 5.9 6.7 6.1 5.2 5.1 5.5 4.9 4.9 5.6 5.2 6.7 5.6 5.1 4.7 5.7 6.2 5.4

[93] 6.0 5.9 7.1 6.2 7.7 5.7 5.4 7.7

hist(lambipirn_sonapikkused)

Teisel katsel tuleb Lambipirni teksti puhul olukord, kus mõned keskmised tulbad on madalamad kui tulbad nende kõrval. Jällegi täiesti loomulik juhtum, samas soovitatakse taolisel puhul teha joonis veidi väiksema arvuga jaotistega.

Mõlema teksti sõnapikkused samal histogrammil. Parameeter fill=lugu värvib kummagi loo sõnapikkused eri värvi, position=identity näitab, et kumbagi andmestikku tasub eraldi näidata; binwidth=2 määrab tulba laiuse.

> sonad %>% ggplot(aes(sonapikkus, fill=lugu)) + geom_histogram(binwidth=2, position="identity", alpha=0.5)

Eelmisel joonisel on näha, et Kungla rahva sõnu on märgatavalt vähem kui lambipirni omi. Üheks võrdsustamise võimaluseks on võtta kummasti loost ühepalju sõnu. Esimesel puhul on replace=TRUE tarvilik, sest Kungla rahva loos pole nõnda palju sõnu võtta ning mõnedel tuleb lubada korduda. Kahe tabeli read saab üheks lisada bind_rows käsu abil

sonad %>% filter(lugu=="kungla") %>% sample_n(100, replace=TRUE) %>% bind_rows(

sonad %>% filter(lugu=="lambipirn") %>% sample_n(100))

# A tibble: 200 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla istus 5 2 1

2 kungla laande 6 3 1

3 kungla sööma 5 3 0

4 kungla ja 2 1 0

5 kungla ja 2 1 0

6 kungla pähe 4 2 1

7 kungla ja 2 1 0

8 kungla siis 4 2 0

9 kungla põksub 6 2 3

10 kungla loomad 6 3 1

# ... with 190 more rows

Sama käsklus ning tulemused saadetakse histogrammi loomiseks edasi. Läbipaistvus aitab üksteise peal olevatel tulpadel välja paista

sonad %>% filter(lugu=="kungla") %>% sample_n(100, replace=TRUE) %>% bind_rows(

sonad %>% filter(lugu=="lambipirn") %>% sample_n(100)) %>%

ggplot(aes(sonapikkus, fill=lugu)) +

geom_histogram(binwidth=2, position="identity", alpha=0.5)

Mitme käivitamise puhul võib tulemus märgatavalt erineda, samas taas näha, et Kungla rahva sõnad rohkem ühte vahemikku koondunud.

Head-käsuga saab tabeli algused kätte nii ühe kui teise loo puhul.

> sonad %>% filter(lugu=="kungla") %>% head()

# A tibble: 6 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 kungla kui 3 2 1

2 kungla kungla 6 2 2

3 kungla rahvas 6 2 0

4 kungla kuldsel 7 2 2

5 kungla aal 3 2 0

6 kungla kord 4 1 2

> sonad %>% filter(lugu=="lambipirn") %>% head()

# A tibble: 6 x 5

lugu sona sonapikkus taishaalikuid sulghaalikuid

<chr> <chr> <int> <int> <int>

1 lambipirn ehk 3 1 1

2 lambipirn aitab 5 3 2

3 lambipirn alljärgnev 10 3 1

4 lambipirn kallitel 8 3 2

5 lambipirn kodumaalastel 13 6 3

6 lambipirn vast 4 1 1

Lihtsamal juhul need arvud t.test-i käsklusesse võrdlusse.

> t.test(c(3, 6, 6, 7, 3, 4), c(3, 5, 10, 8, 13, 4))

Tulemuste seletus:

Tõenäosus, et andmed on samast üldkogumist (p-value, nullhüpotees) on 0.219. Ehk siis ligi 80% on tõenäoline, et sõnapikkuste keskmine neis tekstides on erinev - juba kuue esimese sõna järgi. Allotsas näha kummagi loo algussõnade aritmeetiline keskmine pikkus (4,83 ja 7,17). Nende peal märgitud, et "95% tõenäosusega võime väita, et Kungla rahva loo sõnad on keskmiselt 6,43 tähte lühemad kuni 1,77 tähte pikemad". Kuna esialgu ainult kuut sõna vaadeldi, siis selline suhteliselt lai vahemik mõistetav.

Welch Two Sample t-test

data: c(3, 6, 6, 7, 3, 4) and c(3, 5, 10, 8, 13, 4)

t = -1.3497, df = 6.9072, p-value = 0.2197

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

-6.432546 1.765879

sample estimates:

mean of x mean of y

4.833333 7.166667

Terve loo sõnad ette võttes paistab vahe märgatavalt selgemini välja.

t.test(sonad %>% filter(lugu=="kungla") %>% .$sonapikkus,

sonad %>% filter(lugu=="lambipirn") %>% .$sonapikkus)

Tõenäosus, et sõnapikkused võiksid tekstiti sarnased olla, on vaid 0,0000072, ehk 7,2*10^6 ehk 7.208e-06. Ülejäänud 0.999993 tõenäosusega järelikult on tekstide pikkuse aritmeetiline keskmine erinev. Õigemini kuna võrdlusse on võetud kogu tekstid, siis aritmeetiline keskmine tekstide vahel on mõõtmistulemuste järgi nagunii erinev. Test aga näitab, kuivõrd võib tulemust üldistada - juhul, kui kummalegi lisanduks sama tüüpi tekste. Välja on toodud kummagi teksti keskmine pikkus, samuti et Kungla rahva sõnad on 95% tõenäosusega lühemad 0,6 kuni 1,6 tähte.

Welch Two Sample t-test

data: sonad %>% filter(lugu == "kungla") %>% .$sonapikkus and sonad %>% filter(lugu == "lambipirn") %>% .$sonapikkus

t = -4.6823, df = 126.3, p-value = 7.208e-06

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

-1.6067994 -0.6520951

sample estimates:

mean of x mean of y

4.760000 5.889447

Sama test oludes, kus kummastki loost võetakse 50 juhuslikku sõna

t.test(sonad %>% filter(lugu=="kungla") %>% sample_n(50) %>% .$sonapikkus,

sonad %>% filter(lugu=="lambipirn") %>% sample_n(50) %>% .$sonapikkus)

Welch Two Sample t-test

data: sonad %>% filter(lugu == "kungla") %>% sample_n(50) %>% .$sonapikkus and sonad %>% filter(lugu == "lambipirn") %>% sample_n(50) %>% .$sonapikkus

t = -2.182, df = 79.725, p-value = 0.03205

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

-2.06504226 -0.09495774

sample estimates:

mean of x mean of y

4.54 5.62

Et sõnu vähem kui enne, siis usaldusvahemik laiem. Tõenäosus, et sõnade pikkused tekstides võiksid ühesugused olla on 3%, ehk siis erinevuse tõenäosus 97%

Sarnaselt proportsioonide testile võtame ka siin juhuslikud lähteandmed korduvalt ning jälgime, kuidas tekkinud usaldusvahemikud jaotuvad. Testi tulemuse saab korjata omaette muutujasse

testivastus <- t.test(sonad %>% filter(lugu=="kungla") %>% sample_n(50) %>% .$sonapikkus,

sonad %>% filter(lugu=="lambipirn") %>% sample_n(50) %>% .$sonapikkus)

testivastus

Welch Two Sample t-test

data: sonad %>% filter(lugu == "kungla") %>% sample_n(50) %>% .$sonapikkus and sonad %>% filter(lugu == "lambipirn") %>% sample_n(50) %>% .$sonapikkus

t = -1.6033, df = 91.647, p-value = 0.1123

alternative hypothesis: true difference in means is not equal to 0

95 percent confidence interval:

-1.6119407 0.1719407

sample estimates:

mean of x mean of y

5.00 5.72

Sealt saab edasi kätte usaldusintervalli

testivastus$conf.int

> testivastus$conf.int

[1] -1.6119407 0.1719407

attr(,"conf.level")

[1] 0.95

Hulgi andmete püüdmiseks sobib taas sapply käsklus.

testivastused <- sapply(1:10, function(x){

testivastus <- t.test(sonad %>% filter(lugu=="kungla") %>% sample_n(50) %>% .$sonapikkus,

sonad %>% filter(lugu=="lambipirn") %>% sample_n(50) %>% .$sonapikkus)

c(alates=testivastus$conf.int[1], kuni=testivastus$conf.int[2])

})

Hiljem t- käsklus (ehk transponse) vahetab read ja veerud, et tulemusi oleks mugavam joonisele kanda

t(testivastused)

alates kuni

[1,] -2.993204 -0.84679600

[2,] -2.352419 -0.60758136

[3,] -1.304075 0.50407549

[4,] -2.183304 -0.21669610

[5,] -2.446662 -0.47333790

[6,] -1.253420 0.49341989

[7,] -2.007719 0.08771916

[8,] -2.284946 -0.35505397

[9,] -1.277997 0.35799688

[10,] -2.056415 0.05641494

Joonise loomine. Y-telje väärtused jätame kaare otspunktidel nullile, x-i väärtusteks tulevad tabeli alates ja kuni-tulpade väärtused.